2025.12.24进展汇报

约 967 字大约 3 分钟

2025-12-23

参考的配置教程:

保姆级教程!AirSIM+PX4+QGC从零开始搭建无人机仿真环境。_哔哩哔哩_bilibili

主要工作内容:

一是全流程仿真环境(SITL)的搭建与跑通,二是对寝室/实验室环境的仿真重建与碰撞调试。

1. 仿真环境搭建:

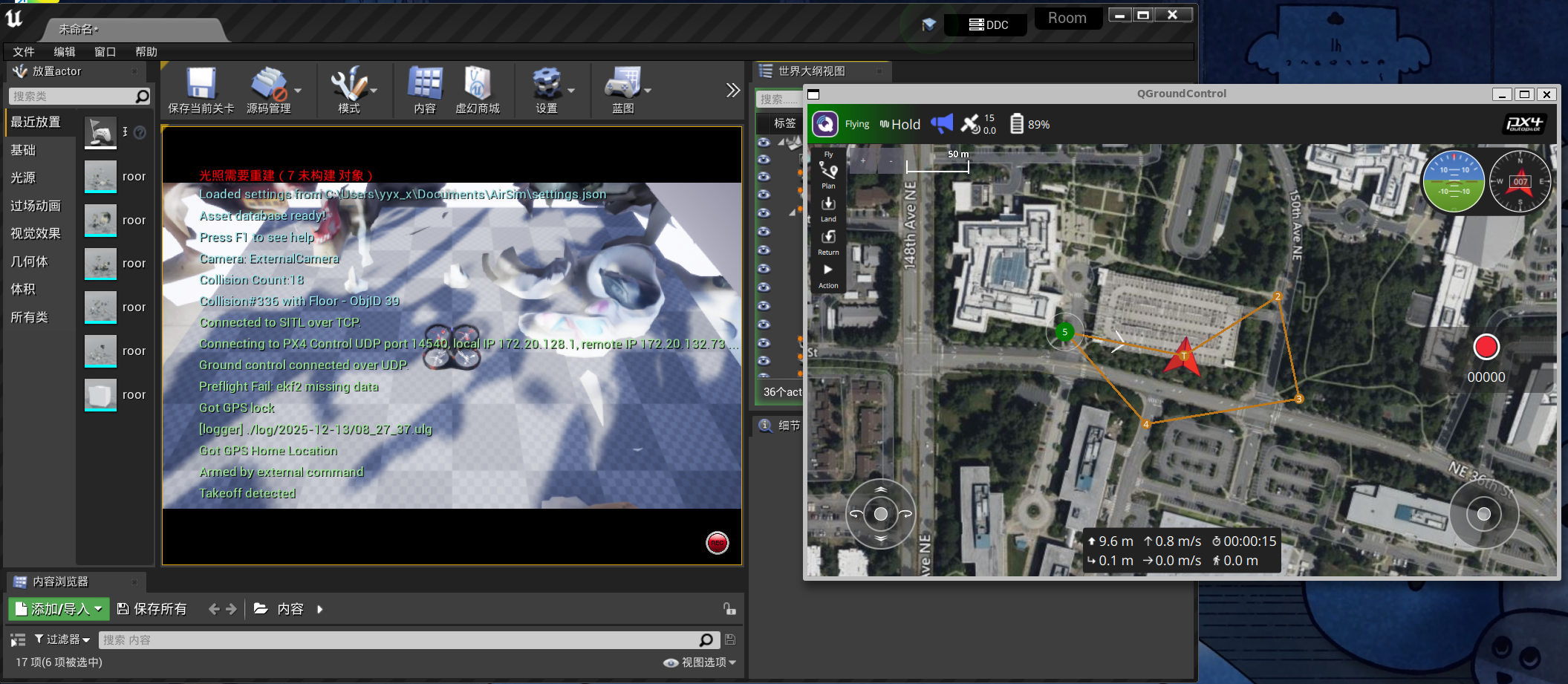

基于 UE → AirSim → PX4 → 地面站 的仿真流。

- 我在UE里面配置了AirSim插件,在 WSL 环境下部署了 PX4 飞控固件。

- 配置了地面站(QGC)与仿真环境的 MAVLink 通信。

- 实现了:从地面站规划航点、手柄实时控制到物理引擎反馈的完整闭环。这为后续算法验证打好了基础。

UE

UE 计算的物理状态,渲染引擎。

AirSim AirSim 是整个系统的数据桥梁。它一方面把 UE 的物理状态转换成传感器数据传给 PX4,另一方面把 PX4 的指令翻译,驱动 UE 里的无人机运动。

PX4 PX4负责所有的姿态解算和飞行控制。

QGroundControl (QGC) QGC 是用户的操作终端。它通过 MAVLink 协议与 PX4 通信,负责下达任务指令和监控飞行状态。

2. 真实环境重建:

如下。

第一次尝试:

建模软件的选择(Polycam):

| 特性 | Polycam (LiDAR 模式) | RealityScan |

|---|---|---|

| 技术原理 | 主要靠激光雷达 (LiDAR) 测距,辅以照片贴图。 | 主要靠多角度照片计算 (Photogrammetry),LiDAR 辅助定位。 |

| 擅长场景 | 空间扫描 (Spaces):扫房间、扫走廊、扫房子结构。 | 物体扫描 (Objects):扫一把椅子、一个背包、一双鞋。 |

| 扫描体验 | 像“刷墙”一样,看到网格覆盖了哪里就扫好了。速度快。 | 需要围绕物体 360 度拍照,依靠云端计算,速度较慢。 |

| 对于寝室 | 适合扫整个房间的“壳”(墙壁、地板、大结构)。 | 适合扫特定的家具(比如乱乱的床、摆满东西的书桌)。 |

综合看来:第一次先试用一下Polycam,因为它可以用手机的雷达来扫描寝室,而RealityScan可能需要拍摄至少上百张的图片来对寝室建模,而且也十分考验拍摄的技巧。

建模流程(简述):

- Polycam扫描并导出obj格式(第一次没怎么仔细扫描,成品十分粗糙)

- 将obj文件导入到blender。进行相关操作:修复坐标、降低面数,使其适配游戏引擎,导出为fbx格式。

- 导入ue4,设置碰撞。

结果(失败):

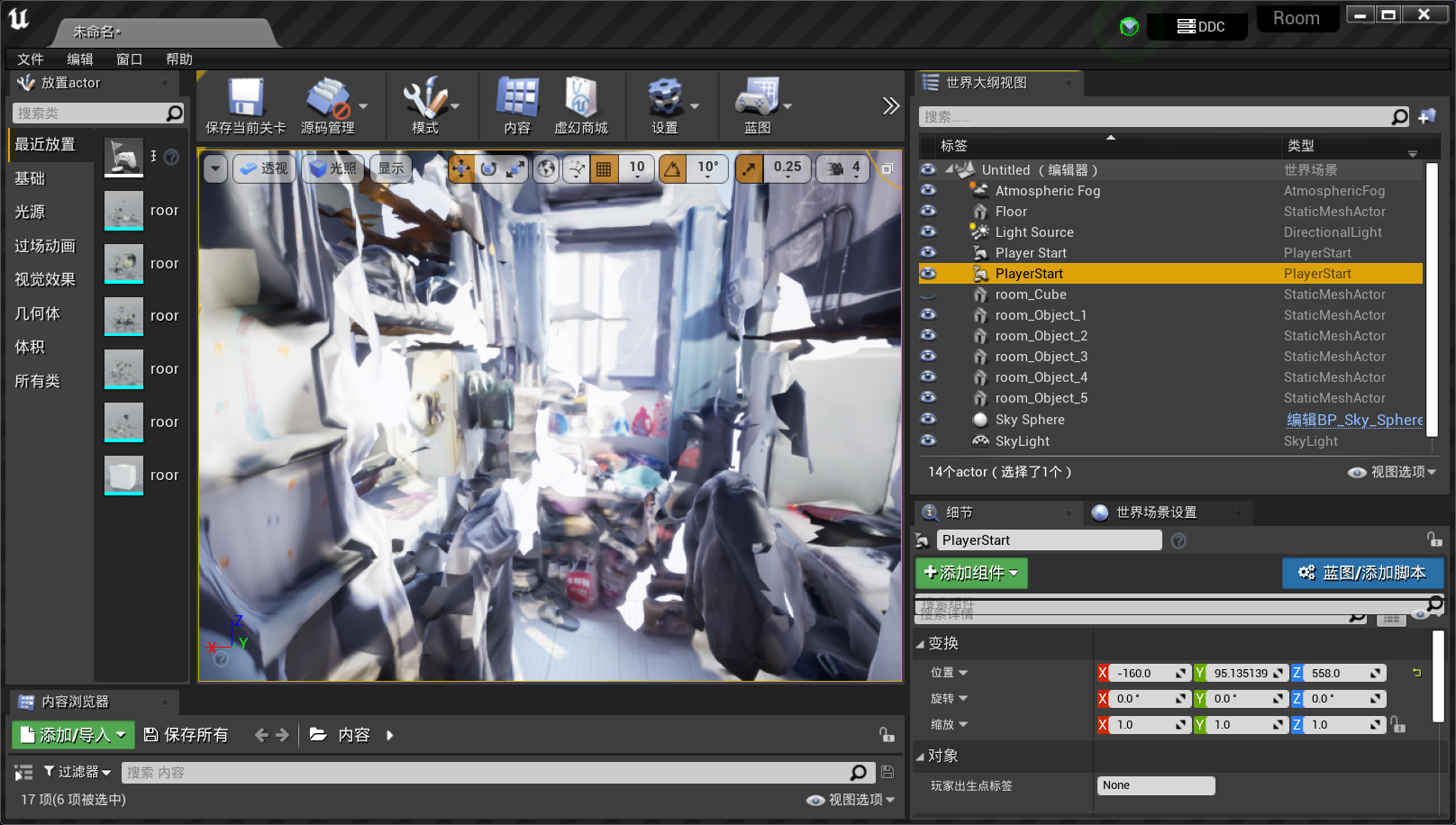

粗糙的建模场景。

px4+地面站控制,无法起飞,卡在地上一直有碰撞。

经验:

之后准备去网上找点教程,详细看看怎么做,这一次是跟着ai做的。

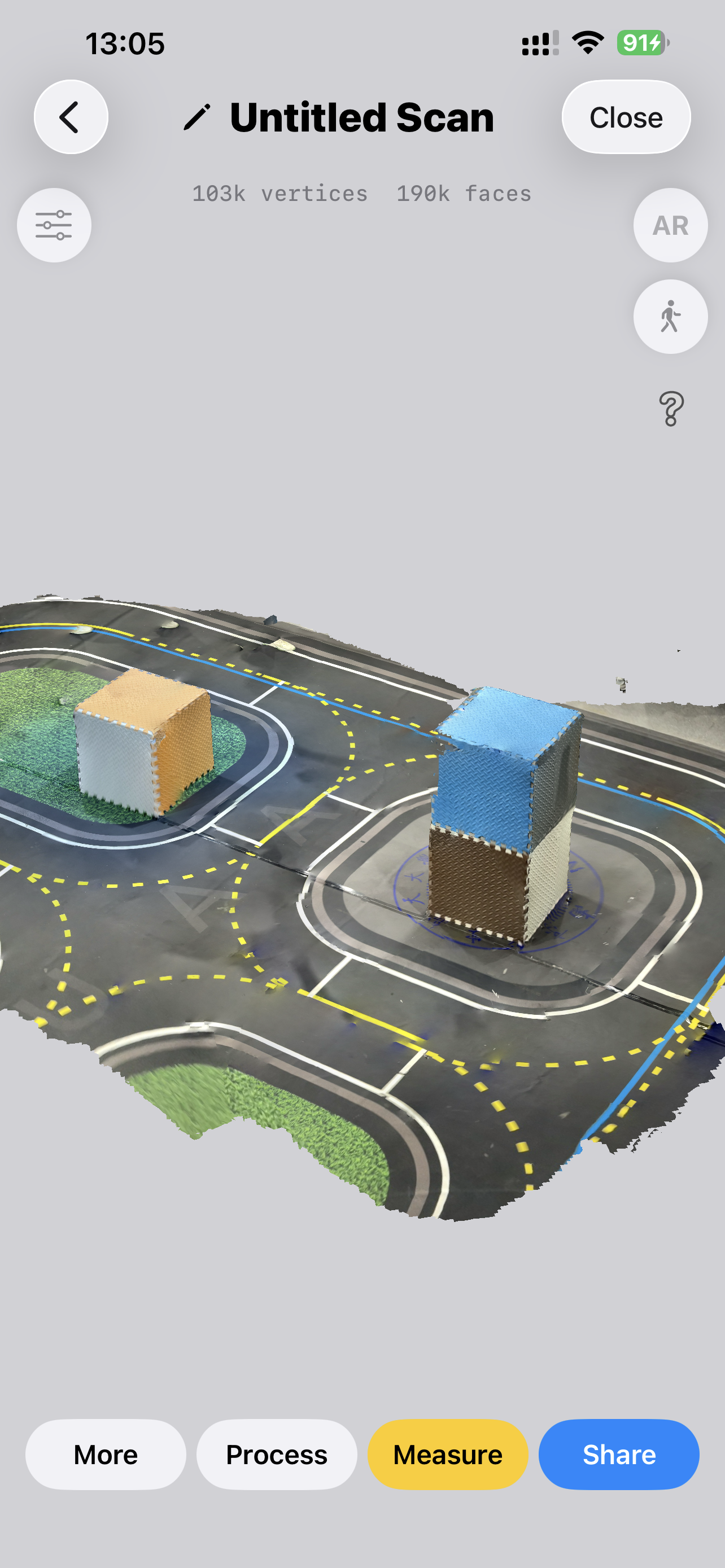

第二次尝试(实验室简单扫描建模):

试了很多扫描软件,效果都不是很好,可能是由于寝室的小物件太多,难以精细扫描。

转念一想,没必要做这么精细的场景,只是为了能跑通流程做一个验证,于是去实验室简单扫描了一个场景。

3D Scanner(ios):

流程:

- 手机扫描场景。

- 导出obj文件,导入Blender做进一步处理(删除一些碎片,减面,设置大小等等),导出为FBX文件。

- 导入UE,做碰撞处理,然后运行Airsim插件,利用px4和地面站控制。

视频展示:

虽然视觉上做了一定简化,但物理属性是完全可用的,满足我们测试避障或规划算法的需求。

后续计划:

可以基于当前简化环境,开始对接算法(例如导航 / VLN / 控制)。