GPT

约 71 字小于 1 分钟

2026-01-27

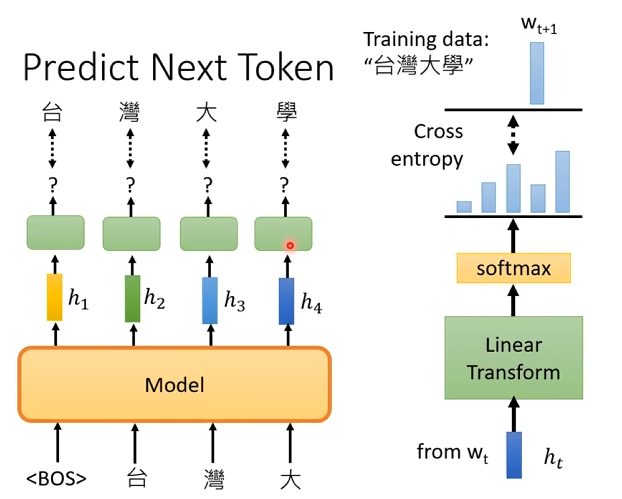

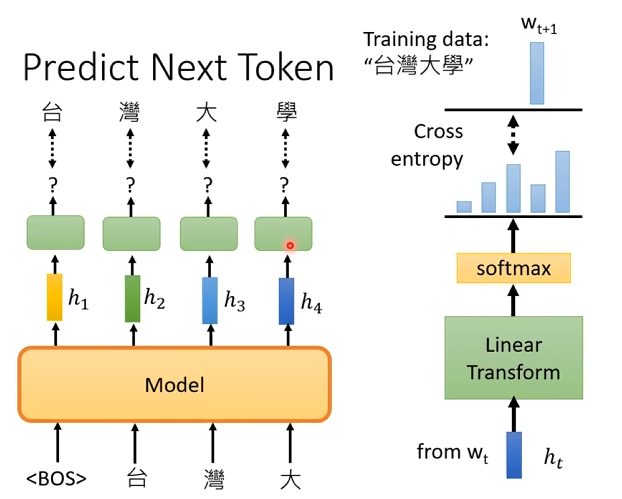

GPT 是一个 decoder-only 的 Transformer,自回归语言模型,用来“生成下一个 token”。

GPT 和 BERT 的根本区别

- BERT:encoder-only,双向,看全文,做理解

- GPT:decoder-only,单向,看左边,做生成

模型

约 71 字小于 1 分钟

2026-01-27

GPT 是一个 decoder-only 的 Transformer,自回归语言模型,用来“生成下一个 token”。